L’origine des ordinateurs numériques

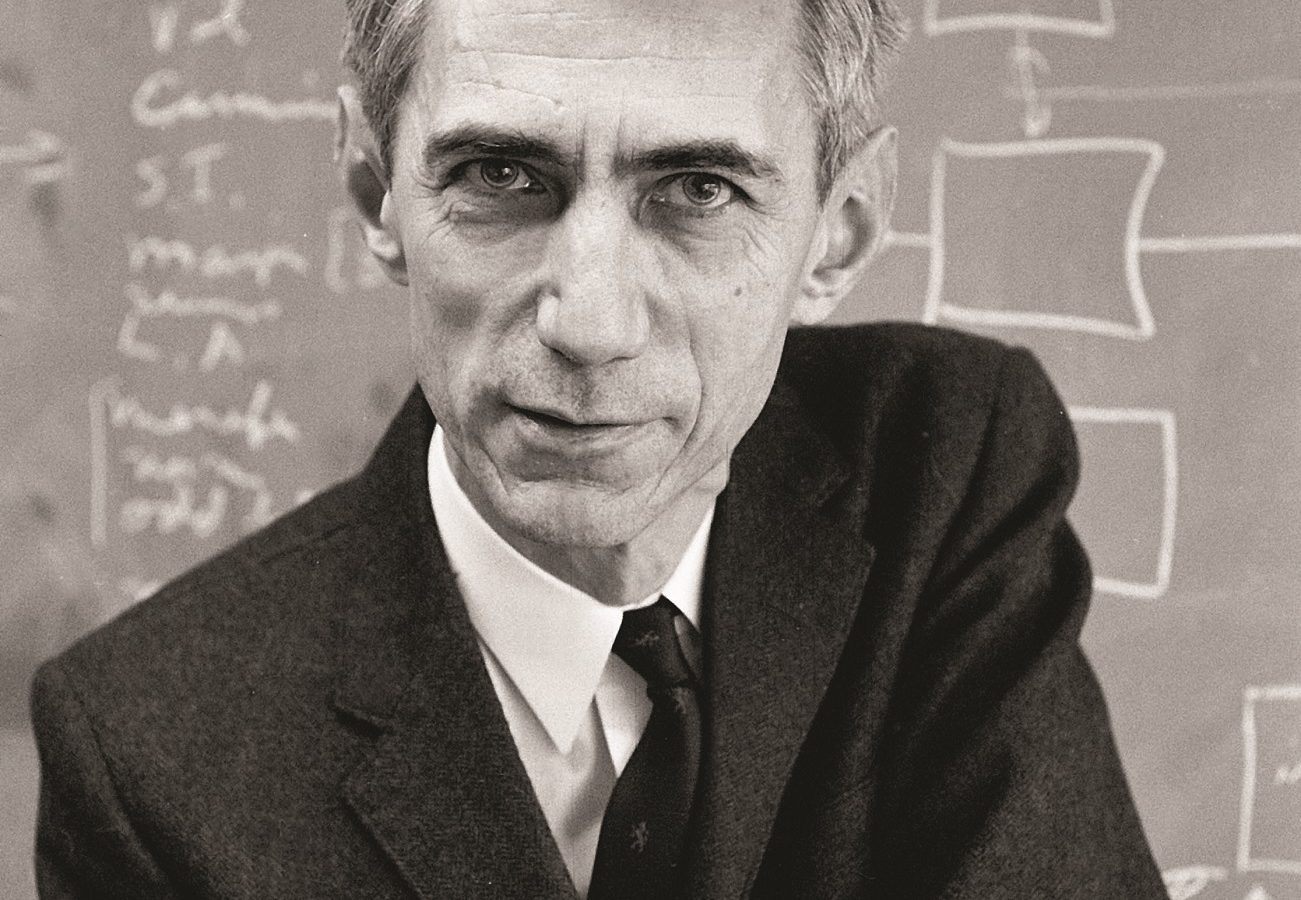

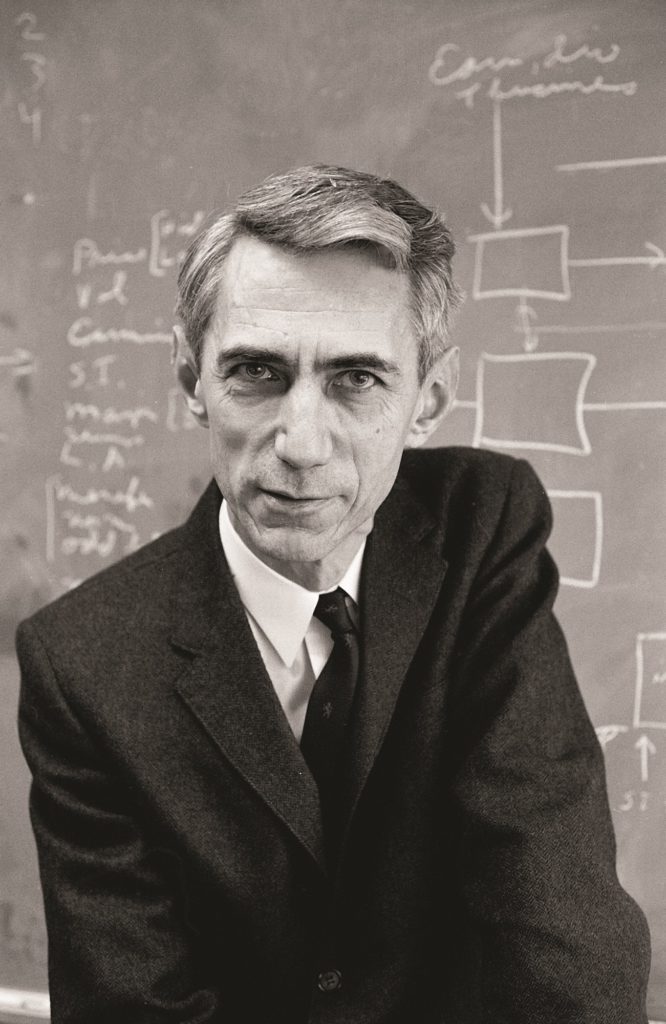

Les premiers ordinateurs étaient des cerveaux mécaniques faits de roues, d’axes et de manivelles, et ils occupaient des salles entières. Puis Claude Shannon, fantaisiste et ingénieux, est entré en scène.

Les premiers ordinateurs étaient des cerveaux mécaniques faits de roues, d’axes et de manivelles, et ils occupaient des salles entières. Puis Claude Shannon, fantaisiste et ingénieux, est entré en scène.

Si vous cherchez l’origine de notre ère de l’information, vous pourriez chercher longtemps. L’information et les machines qui la traitent nous entourent comme le temps qu’il fait, et on sait qu’il est difficile de prédire la prochaine saute de vent ou de retracer l’origine d’une tempête. Mais un petit nombre de personnes fusent tels des éclairs : brillants, révolutionnaires et singuliers. Claude Shannon en est un exemple.

Enfant, c’était un bricoleur. Grandissant dans la toute petite ville de Gaylord, dans le Michigan, dans les années 1920, il a construit un ascenseur dans une grange et a transformé une clôture de fer barbelé en un poste télégraphique secret. Toute sa vie il allait penser d’une manière pratique et à l’aide de ses mains, construisant des ordinateurs qui jouent aux échecs et des souris mécaniques capables de trouver leur chemin dans un labyrinthe.

Shannon n’a pas voulu étudier dans un seul domaine, ce qui n’est pas surprenant quand on sait qu’il allait plus tard apprendre à jongler tout en roulant sur un unicycle. Il a fait un double programme menant à un diplôme en mathématiques et en génie. Il dirait plus tard que cela ne faisait pas partie d’un grand plan d’ensemble. C’est seulement qu’il ne savait pas ce qu’il préférait, les mathématiques ou les machines.

Il a obtenu son diplôme de 1er cycle universitaire en 1936, au cœur de la Grande Dépression, et l’entreprise familiale de meubles et de cercueils a voulu le ramener à la maison. Mais heureusement pour la suite de l’histoire, il a aperçu une carte postale affichée sur un babillard du département de génie, où l’on annonçait rechercher des assistants pour travailler sur un « cerveau mécanique » au MIT.

« J’ai fait beaucoup d’efforts pour obtenir cet emploi, et je l’ai eu », allait-il déclarer plus tard. « Ce fut l’une des plus grandes chances de ma vie. » [traduction]

Au MIT, Shannon a travaillé sur (et dans) le cerveau mécanique, un engin de la taille d’une salle, inventé et supervisé par le célèbre Vannevar Bush. Appelé analyseur différentiel, c’était un ordinateur — mais d’un genre différent de ce que nous connaissons aujourd’hui. Quand M. Bush parlait de cette machine à des étudiants, il commençait en relatant la pomme de Newton tombant de l’arbre. Si la pomme était dans le vide, elle aurait une accélération constante, et l’on pourrait calculer en quelques secondes sa vitesse à un moment quelconque à l’aide d’une seule équation simple. Mais en réalité, la pomme tombe dans l’air, dont la résistance augmente avec la vitesse de la pomme. La vitesse réelle de la pomme est alors régie par 2 équations interreliées. Si l’on ajoute une culbute qui change la résistance, il y a encore plus d’équations à considérer. Dans le monde réel, même un problème simple comme celui de la chute d’une pomme peut rapidement devenir trop complexe pour être résolu au tableau noir.

Vannevar Bush affirmait qu’il valait mieux automatiser ces calculs en construisant une machine. Un axe pourrait représenter l’accélération due à la gravité, et un autre pourrait représenter la résistance de l’air. Ces axes pourraient être reliés à des roues et engrenages qui, littéralement et mathématiquement, intégreraient les 2 accélérations en une seule.

La machine incarnait le problème en obéissant aux mêmes équations différentielles que la pomme en train de tomber. Cette analogie de comportement est ce à quoi on se réfère quand on dit que les premiers ordinateurs étaient analogiques.

Le calcul analogique constituait une démarche fructueuse : l’analyseur différentiel permettait pour la première fois de faire les calculs de choses complexes comme la diffusion des électrons et la charge d’un réseau électrique. Mais au moment où Shannon est arrivé au MIT, la machine avait frappé un mur : il fallait la reconstruire chaque fois que le problème à résoudre changeait, et cette reconstruction prenait trop de temps.

Shannon a rapidement appris que la plus grande partie du travail de conception consistait à modifier la configuration d’une boîte contenant 100 interrupteurs, qui déterminaient à leur tour quels axes tournaient et la manière dont ils étaient reliés. La configuration de ces interrupteurs était établie par essais et erreurs — surtout des erreurs. Tout ingénieur moderne sait que l’agencement des interrupteurs et des connexions entre eux constitue l’essence de la conception d’un circuit, mais à l’époque la conception de circuits était davantage un art qu’une science.

Shannon en a fait une science, plus précisément un exercice mathématique.

Pendant ses études de 1er cycle, Shannon avait pris connaissance des travaux de George Boole, penseur du XIXe siècle qui a mis au point un système pour calculer si des énoncés logiques sont vrais ou faux. À partir des raisonnements de la logique aristotélicienne (tels que « Tous les hommes sont mortels; or Socrate est un homme; donc Socrate est mortel »), Boole a créé un système algébrique pour évaluer des énoncés. Il a noté les valeurs VRAI et FAUX par 1 et 0 respectivement, et a introduit les opérateurs ET, OU, NON et SI, maintenant familiers à tous ceux qui ont écrit ne serait-ce qu’une ligne de programme informatique. L’algèbre booléenne a clairement fait entrer la logique dans le domaine des mathématiques pures.

Pendant les 90 années qui ont suivi l’apparition de l’algèbre booléenne, personne ne s’en est beaucoup servi. Mais pendant que Shannon cherchait à comprendre quels interrupteurs il devait éliminer pour reconfigurer l’ordinateur de Vannevar Bush, il a eu une intuition qu’il a éclaircie par la suite. Ce n’était pas tant que le fait qu’un interrupteur ouvert ou fermé puisse correspondre à un 0 ou à un 1 de Boole, bien que cela fasse partie du tableau. C’était plutôt, selon ce qu’il a dit à un journaliste, le fait que deux interrupteurs en série équivalent à un ET, parce qu’ils doivent être tous deux fermés pour que le courant passe, et que deux interrupteurs en parallèle équivalent à un OU, parce que le courant passe si au moins l’un des deux est fermé. Shannon s’est rendu compte que la conception de circuits pouvait être régie par les règles de l’algèbre de Boole au lieu de se faire par essais et erreurs. On pouvait reconstruire — reprogrammer — assez rapidement la grosse machine de Vannevar Bush en réfléchissant un peu à l’aide d’une feuille de papier et d’un crayon.

De plus, après avoir été réduits à des 1 et des 0, les interrupteurs eux-mêmes sont sortis du tableau. On pouvait les remplacer par bien d’autres choses, à commencer par des tubes à vide, puis des transistors, et c’est ce qui s’est produit. La technologie des ordinateurs a fait un bond en avant. C’était en 1937, et Shannon avait 21 ans.

Il est probable que personne d’autre au monde n’aurait pu réaliser cette percée. Dans une salle pleine d’ingénieurs qui peinaient sur des interrupteurs, il était le seul à connaître les mathématiques de la logique formelle. Et il était aussi probablement le seul, parmi les gens ayant une formation en logique formelle, à avoir dû concevoir un système d’interrupteurs.

Sa contribution à l’informatique était loin d’être terminée. Pendant la guerre, il travaillait en cryptographie, mais il consacrait ses temps libres à un projet secret. Par la suite, il a été embauché par les Laboratoires Bell, ce temple de l’innovation scientifique et technique qui a donné au monde le transistor, le laser et la cellule solaire. Dans les Laboratoires Bell, Shannon était un génie d’entre les génies, circulant sur son unicycle dans les étroits couloirs. Et même à cela, lorsqu’il a finalement révélé les résultats de son projet secret, c’était quelque chose de totalement inattendu.

Cette surprise a pris la forme d’un article publié en 1948 sous le titre A Mathematical Theory of Communication (Une théorie mathématique de la communication). Scientific American allait qualifier un jour cet article de « Magna Carta de la théorie de l’information », le document fondateur d’un domaine entier. Entre autres choses, l’article définissait le chiffre binaire — le bit — et exposait l’idée selon laquelle tout élément d’information pouvait être codé sous forme des chiffres 0 et 1 que Shannon avait attribués aux interrupteurs ouverts et fermés. Lorsque l’on dit que les ordinateurs d’aujourd’hui sont numériques, ces 0 et 1 sont les nombres que nous avons en tête. Si nous vivons à l’ère du numérique, c’est à ce moment-là qu’elle a commencé.

Claude Shannon aimait les particularités profondes de l’univers. Il les maîtrisait pour les transcender dans un monde d’abstraction pure, puis les retraduire dans des machines. Il a appris à jongler, puis a élaboré la première théorie mathématique de la jonglerie, avant de construire un robot jongleur. Il a appris à jouer aux échecs, a redéfini les mathématiques des échecs, puis a écrit l’article définissant la manière de programmer des ordinateurs pour jouer aux échecs. C’était un personnage loufoque : il a construit une trompette lance-flammes et a inventé un ordinateur qui faisait des calculs en chiffres romains. Il n’a jamais cherché la notoriété et a rarement recherché la collaboration. Il était très aimable et très timide. Dans le domaine de la théorie de l’information c’est un dieu. À l’extérieur de ce domaine, il est pratiquement tombé dans l’oubli.

Le père de la théorie de l’information est mort en 2001 de complications de la maladie d’Alzheimer.

Dans son ouvrage le plus récent, Sir Martin Rees, Astronome royal du Royaume-Uni, aborde comment les progrès technologiques rapides de l’humanité menacent — et pourraient ultimement assurer — notre survie en tant qu’espèce. Il a accordé à Dans le périmètre une entrevue au cours de laquelle il explique pourquoi il croit que la science nous procure l’aperçu le plus clair de l’avenir.

Moins prestigieux que les prix Nobel mais beaucoup plus amusants, les prix Ig Nobel récompensent annuellement des recherches qui se distinguent par leur caractère saugrenu.

Ajoutez un brin de merveille scientifique à votre téléphone multifonctionnel, tablette ou ordinateur, avec ces images d’arrière-plan qui suscitent la réflexion.